Das Projekt wird vom Bundesministerium für Bildung und Forschung (BMBF) gefördert. Be-greifen kombiniert anfassbare, manipulierbare Objekte („Tangibles“) mit Technologien der erweiterten Realität („Augmented Reality“), um neue, intuitive Benutzerschnittstellen zu entwickeln. Durch interaktive Experimente soll es möglich werden, den Lernprozess im MINT-Studium aktiv zu unterstützen und den Lernenden theoretische Inhalte der Physik praktischer zu vermitteln.

Professor Paul Lukowicz, der Koordinator des Projekts und Leiter des DFKI-Forschungsbereichs Eingebettete Intelligenz: „Zwischen den eher theoretischen universitären Lehrveranstaltungen und dem Physikunterricht in der Schule, mit seinem Wechselspiel zwischen Experiment und Theorie, besteht eine große Kluft. Durch den Einsatz von eingebauten Sensoren, Kameras oder anderen Tracking-Mechanismen zur Objekterkennung können wir in Echtzeit wesentliche physikalische Variablen wie Position, Zeit, Geschwindigkeit, Beschleunigung oder Gewicht erfassen. Dadurch wird das Experiment zur Benutzerschnittstelle.“

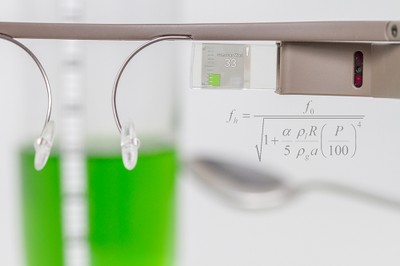

Im Projekt werden Schnittstellen von Smartphones, Smartwatches oder Smartglasses eingesetzt. Beispielsweise eine Datenbrille, mit der man Inhalte durch eine Kombination aus subtilen Kopfbewegungen, Augenblinzeln und Sprachkommandos abrufen und auf einem über dem Auge angebrachten Display betrachten kann. Durch diese beiläufige Informationsverarbeitung werden die Studenten bei der Durchführung des Experiments nicht abgelenkt und können auf die Objekte zugreifen und sie manipulieren.

Ein als Vorstudie entstandenes Experiment verdeutlicht die Entwicklungen von Be-greifen: Dazu haben Wissenschaftler am DFKI und an der Technischen Universität Kaiserslautern gemeinsam eine App entwickelt, die Schüler und Studenten bei der Bestimmung des Zusammenhangs zwischen dem Füllstand eines Glases und der Höhe des Tons unterstützt. Die gPhysics genannte Anwendung erfasst die Wassermenge, misst die Tonfrequenz und überträgt die Ergebnisse in ein Diagramm. Die App lässt sich dabei nur durch Gesten des Kopfes und ohne manuelle Interaktion bedienen. Bei gPhysics wird die Wassermenge mit einer Kamera erfasst und der ermittelte Wert bei Bedarf durch Kopfgesten bzw. Sprachkommandos korrigiert. Das Mikrofon der Google Glass misst die Tonfrequenz. Beide Informationen werden in einem Diagramm dargestellt, das laufend aktualisiert auf dem Display der Google Glass angezeigt wird. So können die Lernenden direkt beim Befüllen des Glases mitverfolgen, wie sich die Frequenzkurve in Relation zum Wasserstand entwickelt. Da die Erzeugung der Kurve vergleichsweise schnell geht, haben die Lernenden die Möglichkeit, direkt während des Interaktionsprozesses verschiedene Hypothesen durch Variation diverser Parameter des Experimentes zu testen.

Im Projekt werden weitere Experimente zu physikalischen Grundlagen der Mechanik und Thermodynamik konstruiert. Außerdem entwickelt das Konsortium Technologien, die es Lernenden ermöglichen Video- und Sensoraufnahmen sowie Analysen ihrer Experimente in einer Cloud zur Diskussion zu stellen und sich mit Kommilitonen darüber auszutauschen oder Ergebnisse zu vergleichen.

Be-greifen wird mit einem Volumen von über zwei Millionen Euro vom BMBF gefördert und läuft bis Juni 2019. Im Projektteam arbeiten neben dem DFKI als Koordinator fünf weitere Partner aus Forschung und Praxis: Die Technische Universität Kaiserslautern, studio klv GmbH & Co. KG aus Berlin, Universität Stuttgart, Con Partners GmbH aus Bremen und die Embedded Systems Academy GmbH aus Barsinghausen.

Kontakt:

Prof. Dr. Paul Lukowicz

Trippstadter Straße 122

67663 Kaiserslautern

Tel.: 0631 20575 -4000

E-Mail: paul.lukowicz@dfki.de