Die Produktion der Zukunft ist nachhaltig, flexibel und vernetzt. Intelligente Systeme agieren autonom oder gemeinsam mit den Menschen und unterstützen ihn bei schwierigen und gefährlichen Arbeiten. Sie nutzen Sensoren als Sinnesorgane, um ihre Umgebung wahrzunehmen und sicher mit uns zusammenzuarbeiten. Besonders optische Sensoren lassen sich vielseitig zur Erfassung von Arbeitsprozessen und -umgebungen einsetzen.

Kombination von 3D-Kameradaten und neuronalen Netzen auf einem integrierten Chip

Im Projekt „ENNOS – Eingebettete Neuronale Netze für Optische Sensoren zur flexiblen und vernetzen Produktion“ wird ein kompaktes Kamerasystem entwickelt, das die Farb- und Tiefeninformationen einer 3D-Kamera direkt auf einem integrierten Prozessor mit tiefen neuronalen Netzwerken (Deep Neuronal Networks) analysiert und verarbeitet.

Die eingesetzten Verfahren des maschinellen Lernens sollen eine leistungsfähigere Interpretation der Kameradaten ermöglichen und haben sehr großes Potenzial, Maschinen in Zukunft anpassungsfähiger zu gestalten. Das neuronale Netz dient dabei als „künstliches Gehirn“ zur Entscheidungsfindung für vordefinierte Fragestellungen und wird auf einem sogenannten FPGA-Chip ausgewertet.

Schnelle und energieeffiziente Berechnungen mit eingebetteten Prozessoren

FPGAs sind integrierte Schaltkreise, die sich nachträglich für unterschiedliche Aufgaben programmieren lassen. Die auf der Embedded-Lösung des ENNOS-Konsortialleiters Bosch eingesetzten FPGAs bieten Vorteile gegenüber klassischen Prozessoren in Bezug auf Flexibilität, Leistung und Energieverbrauch. Aufgrund der begrenzten Kapazität der Chips müssen die programmierbaren Architekturen kleiner und kompakter sein.

Optimierung der neuronalen Netze für kompakte Prozessoren

Die Herausforderung liegt darin, die komplexe Struktur und Größe moderner neuronaler Netze effizient in eine passende und kompakte Prozessor-Architektur umzuwandeln. Wissenschaftler des DFKI-Forschungsbereichs Augmented Vision entwickeln im Projekt Entscheidungsalgorithmen und Methoden, die neuronale Netze in der Anzahl ihrer Neuronen reduzieren und effizienter machen. Dabei werden Netzwerkgröße und Topologie optimiert, beispielsweise durch das Entfernen (Pruning) überflüssiger Neuronen oder deren Verbindungen (Weight Sharing).

Einen weiteren Innovationssprung des Projekts verspricht die Integration von ultra-kompakten 3D-Kameras des assoziierten Projektpartners pmdtechnologies ag, dem weltweit führenden Anbieter für CMOS-basierte 3D Time-of-Flight Bildsensor-Technologie. 3D-Kameras von pmd werden bereits in diversen Smartphones, Augmented-Reality Brillen, Autos und Industrierobotern eingesetzt und ermöglichen zahlreiche Applikationen. Die vielfältig einsetzbaren optischen Sensoren eignen sich in besonderer Weise zur flexiblen und schnellen Erfassung von Informationen über komplexe Zustände und Umgebungen.

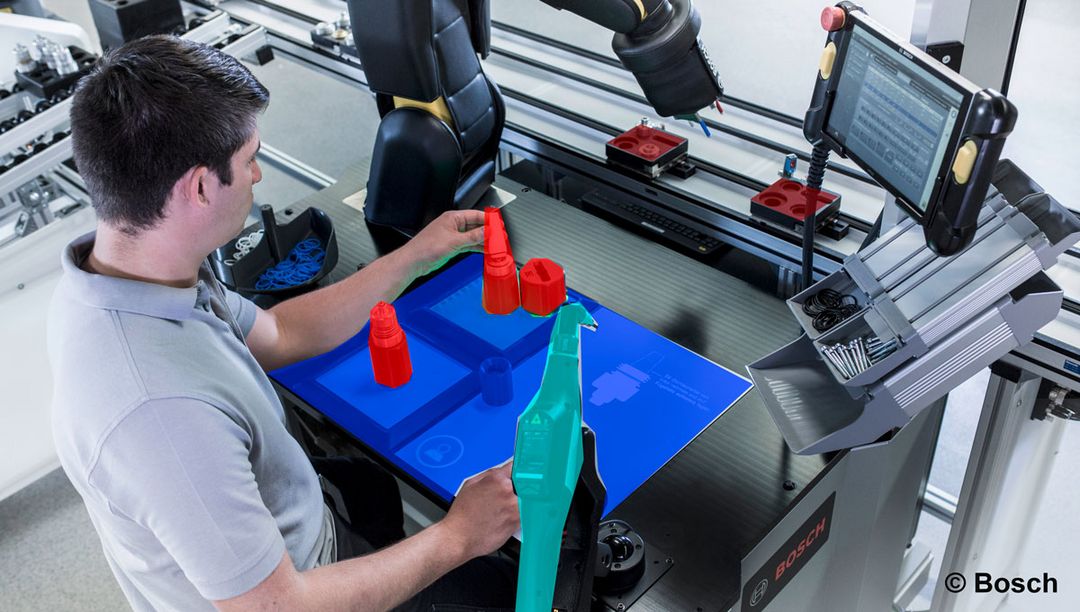

Die neue intelligente Kameraplattform wird in drei verschiedenen Anwendungsszenarien bei den Verbundpartnern eingesetzt:

- Ferndiagnose mit automatischer Anonymisierung von Personen

Beim Einsatz von Kamera- und Softwarelösungen zur videobasierten Ferndiagnose in Fabrikanlagen muss in einer aufwendigen Einzelfallprüfung sichergestellt werden, dass keine personenbezogenen Daten erfasst oder gespeichert werden. Die Projektpartner Bosch und DFKI entwickeln eine neue Anwendung, die Personen erkennt und diese automatisch aus dem Videostream entfernt. Da so nur anonymisierte Videodaten das ENNOS System verlassen, sind alle datenschutzrechtlichen Bedenken einer Ferndiagnose ausgeräumt. - Semantische 3D-Szenensegmentierung für die Robotik

Die Projektpartner DFKI und Bosch arbeiten gemeinsam an der automatisierten semantischen Erkennung von Objekten im industriellen Umfeld. Das Einrichten robotergeführter Manipulationsaufgaben ist sehr zeit- und deshalb kostenintensiv. Um diesen Prozess zu vereinfachen, soll das ENNOS-System automatisiert einfache Konzepte, wie „Palette“, „Bauteil“ oder „Tisch“, erkennen. Die Bereitstellung von semantischen Informationen erlaubt eine intuitivere und damit schnellere, ggf. semantische Programmierung von Arbeitsabläufen. - Assistenzsystem für Bestandsaufnahmen in großen Anlagen

Die Projektpartner KSB und ioxp arbeiten an der automatisierten Erfassung der in großen Produktionsanlagen eingesetzten Komponenten wie Pumpen, Armaturen, Rohren, Sensoren, Anzeigen, Wärmetauschern oder Reaktoren. Die Erkennung soll auf Basis einer hinterlegten Bibliothek erfolgen. Dazu wird die intelligente ENNOS-Kamera an die existierende Augmented-Reality-Lösung von ioxp angebunden. Diese ermöglicht die Prozessdokumentation von industriellen Arbeitsvorgängen in Form von Schritt-für-Schritt-Anleitungen und beinhaltet Verarbeitungsmodule zur Objekt- und Handlungserkennung.

ENNOS wird vom Bundesministerium für Bildung und Forschung (BMBF) im Rahmen der Fördermaßnahme „Photonik für die flexible, vernetzte Produktion – Optische Sensorik“ in den nächsten drei Jahren gefördert. Das Projektvolumen beträgt insgesamt 3,3 Millionen Euro, davon wird fast die Hälfte durch die beteiligten Industriepartner aufgebracht.

Projektpartner:

- Robert Bosch GmbH, Gerlingen-Schillerhöhe (Koordinator)

- Deutsches Forschungszentrum für Künstliche Intelligenz GmbH (DFKI), Kaiserslautern

- KSB SE & Co. KGaA, Frankenthal

- ioxp GmbH, Mannheim

- pmdtechnologies ag, Siegen (assoziierter Partner)

- ifm eletronic GmbH, Tettnang (assoziierter Partner)

Kontakt:

Prof. Dr. Didier Stricker

Forschungsbereich Augmented Vision

Deutsches Forschungszentrum für Künstliche Intelligenz (DFKI) GmbH

Trippstadter Straße 122

67663 Kaiserslautern

Didier.Stricker@dfki.de

Pressekontakt:

DFKI – Team Unternehmenskommunikation

Trippstadter Straße 122

67663 Kaiserslautern

Tel.: +49 631 20575 1700/1710

communications-kl@dfki.de