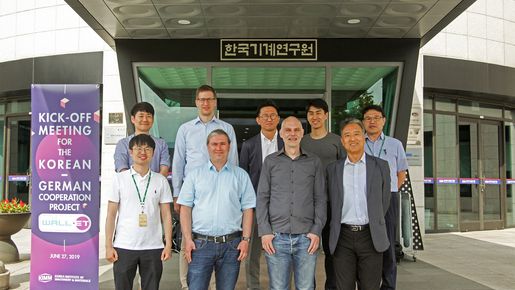

In dem vom Bundesministerium für Bildung und Forschung (BMBF) geförderten „2+2 Projekt“ WALL-ET arbeiten deutsche und koreanische Partner aus Forschung und Industrie an einem sozialen Transportroboter, der mit Hilfe von kognitiven Fähigkeiten Menschen bei der Arbeit in einem Warenlager oder beim alltäglichen Einkauf unterstützen kann. WALL-ET steht für „Warehouse Autonomous Lean Logistics Entity for Transportation“, auf deutsch etwa „autonome robotische Einheit für Transportaufgaben in der Logistik“. Die robotische Plattform selbst wird von dem koreanischen Forschungspartner KIMM (Korean Institute of Machinery & Materials) entwickelt und aufgebaut. Das DFKI wird zusammen mit dem in Saarbrücken ansässigen Korean Institute of Technology Europe (KIST Europe) die notwendige Intelligenz für das System liefern, z.B. Softwaremodule zur Sprachinteraktion, multimodale Dialogführung sowie Aktivitäts- und Intentionserkennung.

Die entwickelte Plattform wird in Deutschland in Zusammenarbeit mit der Globus SB-Warenhaus Holding auf ihre Einsatzmöglichkeiten getestet. Hier bietet das in St. Wendel von den Gründungspartnern Globus, der Universität des Saarlandes und dem DFKI gemeinsam betriebene anwendungsnahe Forschungslabor für den Einzelhandel (Innovative Retail Lab, IRL) die ideale Testumgebung. Durch die Kooperation mit Globus können so auch interessierte Supermarktkunden die neuesten Innovationen erleben. Auf koreanischer Seite wird das entwickelte Robotersystem vom Hersteller für Schreibgeräte Dong-A in der Lagerhalle in Daejeon getestet.

Multimodaler Dialog

Kommerziell erhältliche sprachgesteuerte Assistenzsysteme gibt es inzwischen von vielen Anbietern. Sie konzentrieren sich allerdings auf relativ einfache Sprachkommandos oder -anfragen, wie z.B. „Schalte das Licht im Wohnzimmer ein!“ oder „Wie wird das Wetter heute?“. Menschliche Kommunikation ist allerdings um einiges komplizierter. Wir sprechen und hören nicht nur, sondern setzen weitere sogenannte Modalitäten, wie z.B. Mimik und Gestik ein, und berücksichtigen den Kontext des aktuellen Gespräches und der Umgebung sowohl beim Sprechen als auch bei der Interpretation des Gesagten. Außerdem werden fehlende oder unklare Informationen innerhalb eines Dialoges oft aktiv von den Dialogpartnern erfragt. Multimodale Dialogsysteme nehmen sich dieses menschliche Verhalten zum Vorbild, um auch Gespräche mit Robotern oder digitalen Assistenzsystemen so natürlich wie möglich umzusetzen. Das DFKI forscht seit über 30 Jahren auf dem Gebiet der Künstlichen Intelligenz und hat insbesondere im Bereich der Sprachverarbeitung und multimodalen Dialogführung in Projekten wie Verbmobil oder SmartKom Systeme entwickelt, die noch heute eine Pionierleistung darstellen.

Projektpartner:

Deutschland:

- Korean Institute of Technology Europe, KIST Europe (Konsortialleitung)

- Deutsches Forschungszentrum für Künstliche Intelligenz GmbH, DFKI

- Globus SB Warenhaus Holding

Südkorea:

- Korean Institute of Machinery & Materials KIMM

- DONG-A Pencil Co.

Projektvolumen:

Gesamtvolumen ca. 1 Mio. €

auf deutscher Seite ca. 500.000 €

Projektlaufzeit:

01.04.2019 – 31.03.2022

Kontakt:

Prof. Dr. Antonio Krüger

Leiter Forschungsbereich Kognitive Assistenzsysteme (COS)

Deutsches Forschungszentrum für Künstliche Intelligenz (DFKI)

Campus D3 2

66123 Saarbrücken

Antonio.Krueger@dfki.de

Tel.: +49 681 85775 5075